本文最后更新于:2024年5月7日 下午

矩阵分解是线性代数中的重要操作,本文记录相关内容。

矩阵分解

矩阵分解 (decomposition, factorization) 是将矩阵拆解为数个矩阵的乘积,根据不同矩阵的条件和不同的目的有着不同的矩阵分解方法。

矩阵分解作用

- 矩阵填充(通过矩阵分解来填充原有矩阵)

- 清理异常值与离群点

- 降维、压缩

- 个性化推荐

- 间接的特征组合 (计算特征间相似度)

矩阵分解的方法

| 方法 | 英文 | 应用 |

|---|---|---|

| 特征值分解 | EVD (Eigenvalue Decomposite) | 提取方阵特征 |

| 主成分分析 | PCA (Principal Component Analysis) | 分解,作用,降维、压缩 |

| 奇异值分解 | SVD (Singular Value Decomposition) | 提取任意矩阵特征 |

| 语义分析分解 | LSI (Latent Semantic Indexing) / LSA (Latent Semantic Analysis) | 提取语义分析特征 |

| 概率潜在语义分析 | PLSA(Probabilistic Latent Semantic Analysis) | PLSA和LDA都是主题模型,PLSA是判别式模型。 |

| 非负矩阵分解 | NMF (Non-negative Matrix Factorization) | 非负矩阵分解能够广泛应用于图像分析、文本挖掘和语言处理等领域 |

| 潜在狄利克雷分配模型 | LDA (Latent Dirichlet Allocation) | 文本情感分析、文本分类、个性化推荐、社交网络、广告预测等方面 |

| 概率矩阵分解 | PMF (Probabilistic Matrix Factorization) | 推荐系统中的常用算法 |

| 增强奇异值分解 | SVD++ (Singular Value Decomposition ++) | 在 SVD 算法上进一步做了增强,考虑了用户的隐式反馈。 |

| 矩阵分解模型 | MF (Matrix Factorization) | 可以分为很多种: 还有 正则化矩阵分解(Regularized Matrix Factorization) 和 正交非负矩阵分解(Orthogonal Non-negative Matrix Factorization) |

| 三角分解 | LU | 简化一个大矩阵的行列式值的计算过程,求逆矩阵,和求解联立方程组。 |

| 正交三角分解 | QR分解 | 求一般矩阵全部特征值的有效并广泛应用的方法 |

| 满秩分解 | full rank decomposition | 分解出满秩矩阵 |

| Jordan分解 | Jordan decomposition | 矩阵分解中实用性最广的,只要矩阵是n阶方阵,就可以进行Jordan分解 |

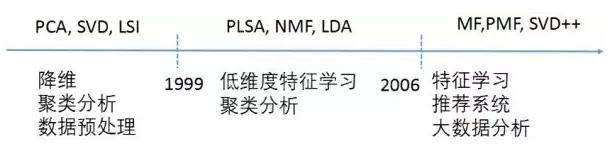

- 阵分解发展的历史:

经典矩阵分解算法

- 经典的主成分分析(PCA)、奇异值分解(SVD)是机器学习入门必学算法。

- 主题模型(LDA)

- 概率矩阵分解(PMF)

- 非负矩阵分解(NMF)

参考资料

- https://blog.csdn.net/qfikh/article/details/103994319

- https://baike.baidu.com/item/矩阵分解/4035386?fr=aladdin

文章链接:

https://www.zywvvd.com/notes/study/linear-algebra/matrix-decomp/matrix-decomp/

“觉得不错的话,给点打赏吧 ୧(๑•̀⌄•́๑)૭”

微信支付

支付宝支付

矩阵分解 -1- 概述

https://www.zywvvd.com/notes/study/linear-algebra/matrix-decomp/matrix-decomp/